Deux équipes de chercheurs ont réussi à redonner la voix à des personnes muettes. Les deux équipes ont utilisé l’IA pour reconnaître les mots exprimés par les personnes et les exprimer à l’aide d’un synthétiseur vocal.

Des chercheurs utilisent des implants reliés à une IA pour permettre à des personnes muettes de communiquer

L’IA a trouvé son utilisation dans la médecine, grâce à elle les personnes muettes peuvent « retrouver leur voix ». Deux équipes de chercheurs californiens ont mis au point un système qui permet aux personnes muettes de « parler » grâce à des implants cérébraux relié à une IA. Les deux équipes ont utilisé des méthodes différentes pour faire fonctionner leur système, mais elles utilisent toutes les deux de l’IA.

La première équipe a publié le fruit de ses recherches sur le média Nature le 23 août dernier. L’équipe a mis au point système qui permet de traduire les signaux électriques des neurones en mots. L’appareil de l’équipe de Francis Willett, neuroscientifique à l’université de Stanford en Californie, est capable de traduire 62 mots par minutes. À titre de comparaison, une conversation normale va à une vitesse de 160 mots par minutes. C’est à peine deux fois plus rapide, mais c’est surtout très engageant pour la suite.

Les chercheurs ont testé leur trouvaille sur Pat Bennett, 67 ans, atteint d’une sclérose latérale amyotrophique. Cette maladie lui fait perdre une partie de ses neurones moteurs et l’empêche de s’exprimer. Pour installer leur dispositif, les chercheurs ont dû installer des électrodes dans la partie du cerveau qui contrôle la parole.

C’est là que l’IA devient utile, les chercheurs ont entraîné l’IA à reconnaître les signaux électriques qu’envoie Pat lorsqu’il prononce certains mots. Les scientifiques ont entraîné l’IA avec un grand groupe de vocabulaire de 125 000 mots et d’un petit groupe de vocabulaire de 50 mots. L’IA est assez précise, elle a un taux d’erreur de 9,1 % sur le petit groupe de vocabulaire. Ce taux passe à 23,8 % sur le plus grand groupe de vocabulaire, mais Francis Willett se veut rassurant.

Environ trois mots sur quatre sont déchiffrés correctement

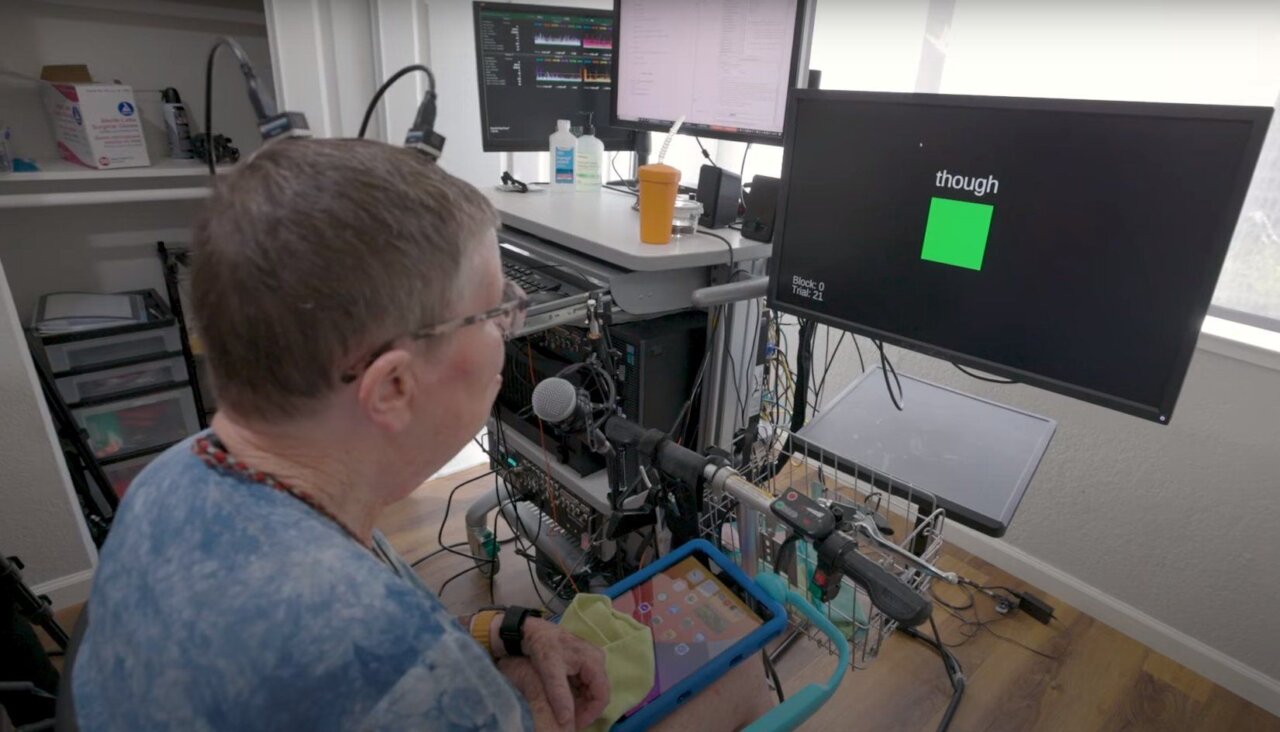

L’équipe de Francis Willett a publié sur la chaîne YouTube de Nature une vidéo montrant comment fonctionne son IA.

On y voit Pat, branché à un ordinateur qui se concentre sur des mots affichés à l’écran. L’IA semble reconnaître assez rapidement ce que lit la sexagénaire.

Une IA et un avatar pour redonner une voix aux personnes muettes

Toujours en Californie, mais à San-Francisco cette fois, une deuxième équipe de chercheurs menée par le neurochirurgien Edward Chang à également trouver un moyen d’utiliser l’IA pour permettre aux personnes muettes de communiquer. Leur méthode est cependant légèrement différente, mais surtout plus rapide. Ici, les chercheurs ont placé 253 microélectrodes, contenues dans un rectangle aussi fin que du papier, sur la surface du cortex d’Ann, une patiente volontaire de 47 ans.

Avec cette méthode, l’appareil d’Edward Chang arrive à traduire 78 mots par minutes, c’est 14 mots de plus qu’avec la première technique présentée. L’équipe a formé des algorithmes d’intelligence artificielle pour reconnaître les schémas d’activité cérébrale d’Ann lorsqu’elle voulait prononcer des mots. Ann a dû prononcer 249 phrases à partir de 1024 mots. La méthode des chercheurs de San-Francisco permet de traduire plus de mots plus rapidement, mais elle a un taux d’erreur plus élevé que celui de la méthode des scientifiques de Stanford. Avec la technique d’Edward Chang, on obtient un taux d’erreur de 25,5 %.

Petit plus, les chercheurs de San-Francisco ont également créé un avatar virtuel affiché sur un écran avec un synthétiseur vocal pour donner plus de vie aux mots synthétisés.

httpv://www.youtube.com/watch?v=–4QfZwS2Rc

L’avatar fait un peu peur, mais c’est déjà exploit de pouvoir permettre aux personnes muettes d’avoir une voix. Les appareils sont assez encombrants, mais il ne fait aucun doute que l’on arrivera plus tard à réduire leur taille et les rendre plus performants, à l’instar des lunettes qui permettent de lire sur les lèvres.

-

LALAHO Clavier Piano 61 Touches avec Support de Clavier, Banc de Piano, Piano Numérique avec Casque, Pupitre, Microphone, Écran LED, pour Débutants (Noir)【Instrument idéal pour les débutants】: Le clavier électronique est équipé de 200 sonorités, 200 rythmes, 60 démos et d’un écran led avec 3 modes d’apprentissage (un doigt, suivi, concert), ce qui en fait l’instrument idéal pour les débutants 【Excellente qualité sonore】: Le clavier du piano dispose de deux haut-parleurs stéréo intégrés. Que vous jouiez ou jouiez des chansons de démonstration, vous pouvez entendre un son clair et tridimensionnel 【Jouez confortablement】: Ce super kit de clavier de piano électrique comprend un support réglable en hauteur et un tabouret épais et rembourré avec un coussin doux qui vous permet de jouer confortablement pendant des heures 【Facile à pratiquer】: Nous fournissons des écouteurs pour que vous puissiez jouer sans vous soucier de déranger les autres. Il est également doté d’une fonction d’enregistrement pour sauvegarder vos morceaux 【Une gamme complète d’accessoires】: Le piano numérique est également livré avec un casque, un pupitre parfait pour tenir des partitions ou des tablettes, un microphone et un adaptateur d’alimentation

-

Clavier Piano Enfant 37 Touches Pianos avec Microphone Jouet Musical Portable pour Enfants 3 4 5 Ans Garçons Filles Cadeau Noël Anniversaire【Clavier piano nouveau design pour débutants】Comparé à d’autres modèles, notre piano permet de jouer des accords faciles. Le design unique des touches en bois donne aux enfants l’impression de jouer sur un vrai piano. De plus, ce clavier piano pour débutants est doté de la fonction « Enregistrement et lecture » qui permet aux enfants de créer et d’enregistrer leurs propres morceaux. Idéal pour les garçons et les filles de 3, 4, 5, 6, 7 et 8 ans, pour débuter en pratique, en studio ou pour jouer en home cinéma. 【Apprentissage des bases de la théorie musicale】Qui ne sauterait pas de joie en déballant ce jouet musical ? Ce piano pour enfants intègre 8 rythmes, 8 sonorités, 19 démos, 4 percussions et 4 cris d’animaux, un contrôle du volume et du tempo, et sa conception unique à deux haut-parleurs produit des sons et des effets de haute qualité. Encouragez les enfants à explorer différentes combinaisons sonores. Qu’il s’agisse d’expérimenter de nouveaux rythmes ou de tester un tempo différent, c’est l’initiation parfaite aux instruments de musique. 【Cadeaux pour garçons et filles de 3 4 5 6 ans】Vous cherchez un cadeau pour votre fils, votre fille ou l’enfant d’un ami ? Ne cherchez plus ! Ce petit piano pour enfants est fabriqué en ABS, un matériau écologique, sûr et très adapté aux enfants. Ce piano est le cadeau idéal pour les filles et les garçons de 3, 4, 5 et 6 ans, pour un anniversaire, la fête des enfants, Noël ou toute autre occasion festive. N’attendez plus ! Emportez-le chez vous ! 【Jouets musicaux pour filles et garçons de 3 ans et plus】Ce piano à 37 touches vous aidera à apprendre à vos enfants des rythmes ou d’autres notions de solfège. Équipé d’un petit microphone, il permet non seulement de jouer du piano, mais aussi de chanter, ce qui contribue à développer leurs compétences musicales et leur donne confiance en eux. Apprendre à jouer du piano électrique permet de développer d’autres compétences musicales et cognitives, c’est gagnant. 【Deux modes d’alimentation】Ce piano portable est livré avec un câble d’alimentation. Utilisez un adaptateur secteur standard américain (non inclus) et branchez-le sur une prise murale pour le charger. Vous pouvez également l’alimenter avec 3 piles AA (non incluses). Le piano mesure 43 x 16 x 5,4 cm (17 x 6,3 x 2,1 pouces), ce qui le rend facile à transporter. Que vous soyez en voyage ou à la maison, les enfants peuvent l’utiliser quand ils le souhaitent.